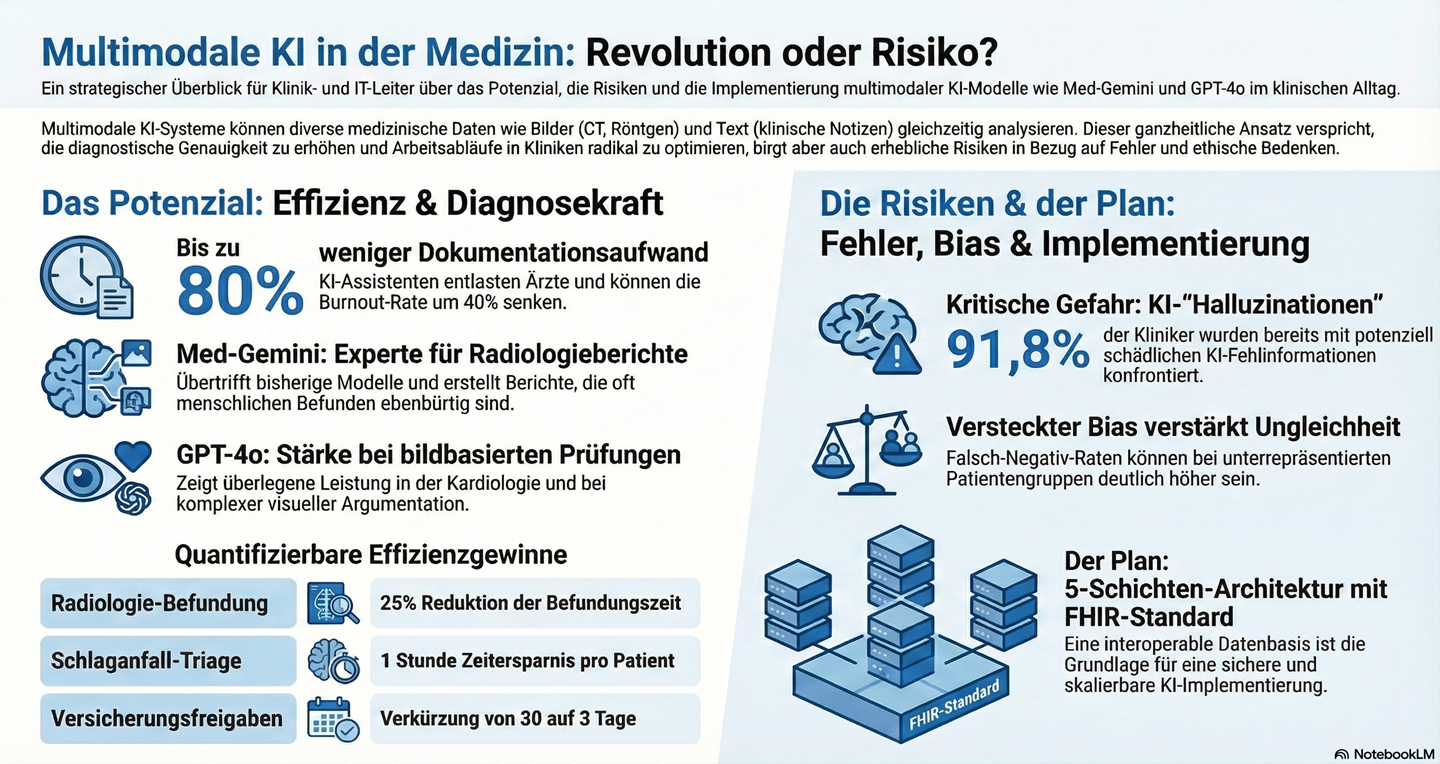

Multimodale KI markiert einen Paradigmenwechsel in der klinischen Diagnostik. Modelle wie Med-Gemini und GPT-4o zeigen in Benchmarks zwar hohe Leistungsfähigkeit, doch signifikante Risiken durch Halluzinationen und systemische Governance-Defizite stellen Implementierungsbarrieren dar. Für IT-Entscheider im Gesundheitswesen unterstreicht dies die Notwendigkeit, vor der Anschaffung isolierter KI-Lösungen eine strategische, auf HL7 FHIR basierende und interoperable Datenarchitektur zu etablieren, um Risiken zu managen und Potenziale sicher zu heben.

Benchmark-Realität: Differenzierte Leistungsprofile von Med-Gemini und GPT-4o

Die Analyse führender multimodaler Modelle offenbart distinkte Stärkenprofile, die für den gezielten klinischen Einsatz relevant sind. Während Med-Gemini eine tiefe Spezialisierung aufweist, demonstriert GPT-4o eine hohe Robustheit bei generalistischen diagnostischen Aufgabenstellungen.

Im Diagnostic Radiology In-Training (DXIT) Examen erreichte GPT-4o eine Genauigkeit von 69,8 % und übertraf damit Gemini Advanced (60,4 %), auch wenn dieser Unterschied statistisch nicht signifikant war (p = 0,151). Entscheidend sind jedoch die Leistungsunterschiede in Subdisziplinen: In der kardiologischen Radiologie deklassierte GPT-4o Gemini Advanced mit 70 % zu 30 %. Zudem untermauert die Überlegenheit bei bildbasierten Fragen (57,8 % vs. 43,8 %) die ausgereiftere visuelle Argumentationsfähigkeit von GPT-4o.

Im Gegensatz dazu liegt die Stärke von Med-Gemini in der spezialisierten, automatisierten Radiologie-Berichterstellung. Das Modell Med-Gemini-2D übertrifft bisherige State-of-the-Art-Modelle in diesem Bereich um 1 % bis 12 %. Darüber hinaus demonstriert Med-Gemini-3D als erstes Modell die Fähigkeit zur Interpretation volumetrischer 3D-CT-Daten, wobei über 50 % der generierten Berichte zu denselben Behandlungsempfehlungen wie die von menschlichen Experten führten.

In Expertenbewertungen wurde Med-Gemini-2D bei 57 % der Normalbefunde und 43 % der abnormalen Befunde als ebenbürtig oder den von menschlichen Radiologen erstellten Berichten überlegen eingestuft. Diese Benchmark-Werte maskieren jedoch systemische Risiken wie eine inkonsistente Performance-Verteilung, die eine tiefere Analyse erfordern.

Systemische Risiken: Halluzinationen und Fehldiagnosen als Implementierungsbarriere

Trotz beeindruckender Benchmark-Ergebnisse bergen multimodale Modelle systemische Risiken, die eine unkontrollierte Implementierung im klinischen Alltag verhindern. Die Fehlerquellen sind oft systematischer Natur und unterscheiden sich fundamental von menschlichen kognitiven Fehlern.

Eine Analyse von GPT-4o zeigt, dass die häufigsten Fehlerkategorien nicht unterstützte medizinische Behauptungen (40,69 %) sowie vage oder falsche Schlussfolgerungen (22,07 %) sind. Die strategisch relevante Erkenntnis ist, dass Fehler in den Domänen der klinischen Anwendung (76,83 % Genauigkeit) und Analyse (76,54 %) signifikant häufiger auftreten als bei der reinen Wissensabfrage („Verständnis“ mit 90,10 % Genauigkeit), was auf eine Schwäche in der höheren klinischen Urteilskraft hindeutet.

Das Phänomen der Halluzination, bei dem Modelle Fakten erfinden, ist tief in der Funktionsweise verankert. Studien zeigen, dass 64–72 % der Halluzinationen auf kausale oder zeitliche Fehlinterpretationen der Daten zurückzuführen sind.

Die Brisanz dieses Problems wird durch eine Umfrage unter Klinikern verdeutlicht: 91,8 % waren bereits mit KI-Halluzinationen konfrontiert, und 84,7 % stufen diese als potenziell gesundheitsschädlich ein [27]. Hinzu kommt das Risiko der „bimodalen Verteilung“, bei der Modelle Fälle entweder perfekt lösen oder völlig falsch bewerten, was auf ein fehlendes tiefgreifendes klinisches Verständnis hindeutet.

Architektonische Grundlage: Die Notwendigkeit einer interoperablen Datenstrategie

Die sichere und skalierbare Integration von KI erfordert mehr als die Anschaffung einzelner Algorithmen; sie verlangt eine strategische architektonische Grundlage. Ein 5-Schichten-Modell bietet hierfür einen strukturierten Rahmen für Krankenhaus-IT-Systeme.

Die Analyse des Reifegrads dieser Architektur in Kliniken zeigt eine kritische Lücke: Während die anwendungsnahe „Application Layer“ am weitesten entwickelt ist (Reifegrad 3,17 von 5), ist die für Governance zuständige „Security and Compliance Layer“ mit 1,69 von 5 Punkten die am schwächsten ausgeprägte Schicht.

Das technische Rückgrat zur Schließung dieser Lücke ist der HL7 FHIR-Standard. Die Umstellung von Legacy-Systemen auf eine FHIR-basierte Architektur schafft quantifizierbare Effizienzvorteile (siehe Tabelle).

| Kennzahl | Legacy-Integration (HL7 v2) | Verbesserung durch FHIR |

| Implementierungszeit | 8–14 Monate | auf 6–10 Wochen |

| Datenabfrage | Baseline | + 58 % |

| Interface-Entwicklung | Standard | – 73 % |

| Wartungsaufwand | Hoch | – 41 % |

Trotz dieser evidenten Vorteile bleibt der Mangel an interner FHIR-Expertise die größte Implementierungsbarriere für IT-Abteilungen in Kliniken.

Governance-Defizit: Algorithmischer Bias als organisationales Risiko

Dieses architektonische Defizit manifestiert sich direkt in einem unzureichenden Governance-Rahmen, wodurch KI-Systeme drohen, bestehende gesundheitliche Ungleichheiten zu verstärken. Die zentralen Quellen für algorithmischen Bias im klinischen Kontext sind Repräsentations-Bias (unausgewogene Trainingsdaten), historischer Bias (Übernahme gesellschaftlicher Vorurteile) und Label-Variabilität (subjektive Experten-Annotationen).

Die Konsequenzen sind messbar und klinisch relevant. So führt Repräsentations-Bias bei der Pneumonie-Erkennung zu einer um 23 % höheren Falsch-Negativ-Rate bei Patienten aus unterrepräsentierten ländlichen Regionen, was zu direkten Versorgungsnachteilen führt [28].

Zur Prävention von Bias sind strategische Gegenmaßnahmen unerlässlich. Dazu gehören die systematische Subgruppen-Analyse zur Überprüfung der Modell-Performance über verschiedene demografische Gruppen hinweg, die feste Etablierung eines „Clinician-in-the-Loop“-Prinzips zur Validierung von KI-Entscheidungen sowie der Einsatz technischer Erklärbarkeit (Explainability), um die Entscheidungsgrundlage der KI transparent zu machen.

Strategische Implikationen

Für Klinik-IT-Leiter und Chief Digital Officers ergeben sich aus der Analyse folgende handlungsorientierte Empfehlungen:

- Technisch: Die Implementierung einer FHIR-basierten Datenplattform ist keine Option, sondern die unbedingte technische Priorität. Diese interoperable Grundlage ist die Voraussetzung für die sichere und skalierbare Integration zukünftiger KI-Anwendungen und muss vor der Anschaffung isolierter Insellösungen etabliert werden.

- Regulatorisch/Organisatorisch: Die Etablierung lückenloser Validierungs- und Monitoring-Prozesse zur Kontrolle von Halluzinationen und algorithmischem Bias ist zur Risikominimierung zwingend erforderlich. Fordern Sie bei der Beschaffung von KI-Lösungen Transparenz bezüglich der demografischen Verteilung der Trainingsdaten, um deren Eignung für Ihre spezifische Patientenpopulation zu gewährleisten.

- Organisatorisch: Positionieren Sie KI konsequent als Assistenzsystem („Second Reader“), nicht als autonomen Entscheider. Nutzen Sie die Technologie zur Effizienzsteigerung bei repetitiven Aufgaben, wie der Reduktion der Dokumentationslast um bis zu 80 %, und zur Risikominimierung durch die Erkennung übersehener Befunde.

Diskussionsimpuls

Wie priorisieren Sie in Ihrer Organisation den strategischen Aufbau von FHIR-Kompetenz gegenüber der Anschaffung spezifischer KI-Algorithmen, um die identifizierte Governance-Lücke (Reifegrad 1.69/5) zu schließen?

27.12.2025, Olaf Dunkel – http://www.olafdunkel.com

© 2025 Dieser Beitrag beruht auf eigenständiger Recherche und Analyse diverser Quellen;eine KI leistete lediglich sprachliche Unterstützung, die inhaltliche Verantwortung trägt ausschließlich der Autor.

Schreibe den ersten Kommentar