Der Deepfake-Diskurs hat sich von politischer Desinformation zu einer Bedrohungen systemischer, ökonomischer und kognitiver Stabilität gewandelt. Die Datenlage der Jahre 2024-2025 offenbart eine fundamentale Fehleinschätzung der Risiken. Die größte Gefahr liegt nicht in der perfekten technischen Täuschung, sondern in der permanenten kognitiven Überlastung, der Begünstigung falscher Erinnerungen in bis zu 28 % der Fälle und der Erosion institutionellen Vertrauens. Gegen diese Effekte bleiben rein technische Detektionsansätze strukturell wirkungslos.

2. Die neurokognitive Schwachstelle: Mehr als nur Täuschung

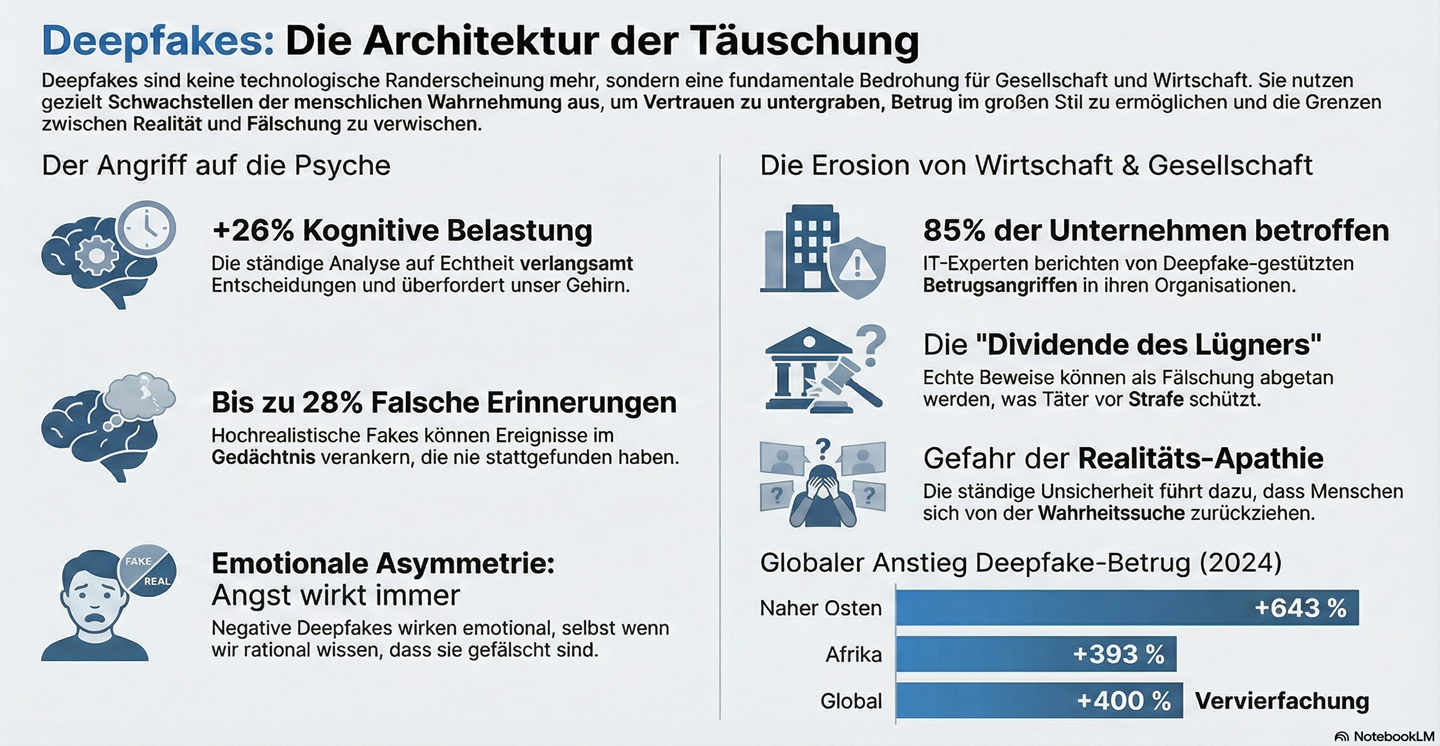

Deepfakes nutzen gezielt die Architektur der menschlichen Wahrnehmung aus. Ihre Verarbeitung verursacht eine messbare kognitive Belastung von bis zu 26 %, was kritische Entscheidungsprozesse nachweislich verlangsamt. Dieser Effekt resultiert aus dem Versuch des Gehirns, subtile visuelle Inkonsistenzen zu verarbeiten, was Ressourcen des Arbeitsgedächtnisses bindet.

Die emotionale Verarbeitung von synthetischen Medien ist asymmetrisch. Während die neuronale Reaktion auf positive Reize wie ein Lächeln signifikant abnimmt, sobald ein Inhalt als KI-generiert erkannt wird, bleibt die physiologische Reaktion auf negative Stimuli stabil. Bedrohungssignale wie Wut werden vom Gehirn weiterhin mit hoher Priorität verarbeitet, unabhängig von der vermuteten Authentizität der Quelle.

Zudem offenbart sich ein „Paradox der Detektion“. Die tief verankerte „‚Sehen-ist-Glauben‘-Heuristik“ führt dazu, dass Menschen ihre Fähigkeit, Fälschungen zu identifizieren, systematisch überschätzen. Die tatsächliche Erkennungsleistung liegt oft auf Zufallsniveau, wobei Personen mit der geringsten Kompetenz das höchste Selbstvertrauen aufweisen. Diese Diskrepanz macht Individuen besonders anfällig für Manipulation.

3. Die Ökonomie des Betrugs: Phishing 3.0 als operatives Risiko

Deepfake-gesteuerter Betrug hat sich zu einem primären Geschäftsrisiko entwickelt. Aktuelle Daten zeigen, dass 85 % der IT-Sicherheitsexperten von Deepfake-Vorfällen in ihren Organisationen berichten. Das globale Ausmaß des Problems wird durch die dramatischen regionalen Wachstumsraten des Identitätsbetrugs illustriert, insbesondere in Afrika (+393 %) und dem Nahen Osten (+643 %).

Die finanzielle Dimension ist signifikant. Fast 20 % der von solchen Angriffen betroffenen Organisationen verzeichneten Verluste von über einer halben Million US-Dollar. Ein prägnantes Beispiel aus Deutschland Anfang 2025 illustriert die Skalierung: Ein Automobilzulieferer verlor durch einen Stimmklon-Angriff auf einen Mitarbeiter 4,2 Millionen Euro.

Die Bedrohung eskaliert durch die Kommodifizierung krimineller Werkzeuge hin zu einem Modell des „Social-Engineering-as-a-Service“ (SEaaS). Kriminelle Syndikate bieten fertige Angriffspakete an, die es technisch unversierten Akteuren ermöglichen, hochkomplexe, KI-gesteuerte Multi-Channel-Angriffe zu starten. Prognosen schätzen die Schäden allein in den USA bis 2027 auf 40 Milliarden US-Dollar.

4. Governance-Lücken: Die Asymmetrie regulatorischer Maßnahmen

Regulatorische Initiativen wie der EU AI Act versuchen, der Bedrohung durch Transparenzpflichten zu begegnen. Artikel 50 des Gesetzes verpflichtet Anbieter und Nutzer von KI-Systemen, synthetische Inhalte klar und maschinenlesbar zu kennzeichnen. Dies soll eine informierte Rezeption durch den Endnutzer sicherstellen.

Die zentrale Governance-Lücke dieser Ansätze liegt jedoch in ihrer mangelnden Durchsetzbarkeit gegenüber bösartigen Akteuren. Die Kennzeichnungspflicht erzeugt eine „Asymmetrie der Kennzeichnung“: Während legale und oft harmlose Inhalte als KI-generiert markiert werden, bleibt gezielte Desinformation unmarkiert und profitiert von einer unverdienten Glaubwürdigkeitsprämie.

Zusätzlich scheitern technologische Abwehrmechanismen an der Generalisierung. Eine Studie der australischen Forschungsbehörde CSIRO belegt, dass die Genauigkeit von Detektionsmodellen auf unter 50 % sinkt, wenn sie mit Fälschungen konfrontiert werden, die durch ihnen unbekannte Generierungstechniken erstellt wurden. Dies macht eine alleinige Verankerung der Sicherheit in Detektionssoftware unhaltbar.

5. Die epistemische Krise: Wenn Beweise ihren Wert verlieren

Die Langzeitfolgen der Deepfake-Technologie betreffen die Grundlagen des gesellschaftlichen Wissens. Die permanente Konfrontation mit potenziell gefälschten Inhalten führt zu „Realitäts-Apathie“, einer kollektiven Resignation bei der Wahrheitsfindung aufgrund kognitiver Überlastung. Individuen ziehen sich auf bestehende Überzeugungen zurück, anstatt Informationen objektiv zu bewerten.

Eine der gravierendsten Folgen ist die gezielte Manipulation des Langzeitgedächtnisses. Studien belegen, dass die Exposition gegenüber hochrealistischen Deepfakes von nie stattgefundenen Ereignissen zur Bildung falscher Erinnerungen bei 15 % bis 28 % der Probanden führen kann. Dieser Effekt untergräbt die Integrität von Zeugenaussagen und die Verlässlichkeit historischer Dokumentation.

Ein paradoxer Nebeneffekt ist die „Liar’s Dividend“ (Dividende des Lügners). Die bloße Möglichkeit von Fälschungen erlaubt es Tätern, authentisches Beweismaterial als Deepfake zu diskreditieren. Dies untergräbt die Rechenschaftspflicht von Personen des öffentlichen Lebens und stellt ein reales Hindernis für die Justiz dar, da der Wert visueller Beweismittel systematisch erodiert.

6. Strategische Implikationen

Die dargelegten kognitiven, ökonomischen und epistemischen Schwachstellen belegen die Insuffizienz rein technischer Abwehrmaßnahmen und erzwingen eine Verlagerung hin zu einem mehrschichtigen, mensch-zentrierten Resilienz-Modell.

- Technisch-Organisatorisch: Implementierung einer Zero-Trust-Architektur für Audio- und Videokommunikation ist unumgänglich. Prozesse wie die verbindliche Out-of-Band-Authentifizierung für sensible Anweisungen müssen etabliert werden. Parallel dazu sollten Organisationen Provenienz-Standards wie C2PA zur kryptografischen Sicherung ihrer eigenen Kommunikation nutzen.

- Regulatorisch-Strategisch: Die Durchsetzung des EU AI Act muss durch die Definition robuster technischer Standards im „Code of Practice“ gewährleistet werden. Nur so kann die Resilienz von Wasserzeichen und Kennzeichnungen gegen Manipulation sichergestellt und die Asymmetrie der Kennzeichnung verringert werden.

- Mensch-zentriert (Human Firewall): Investitionen müssen von reinen Detektionsschulungen hin zur Förderung „epistemischer Handlungsfähigkeit“ verlagert werden. Dies erfordert eine Kultur der „psychologischen Sicherheit“, in der Mitarbeiter für das kritische Hinterfragen von Anweisungen belohnt werden, ergänzt durch regelmäßige psychologische Inokulations-Übungen („Booster Shots“).

7. Diskussionsimpuls

Wie bewerten Sie die Wirksamkeit von Provenienz-Standards wie C2PA im Unternehmenskontext, wenn gleichzeitig die „Liar’s Dividend“ die Glaubwürdigkeit jeglichen visuellen Materials untergräbt?

29.12.2025, Olaf Dunkel, https://www.olafdunkel.com

© 20245Dieser Beitrag beruht auf eigenständiger Recherche und Analyse diverser Quellen; eine KI leistete lediglich sprachliche Unterstützung, die inhaltliche Verantwortung trägt ausschließlich der Autor.

Schreibe den ersten Kommentar